引言:AI的“内心独白”

想象一位技艺精湛的钢琴家,当她弹奏一首复杂的乐曲时,她不仅仅是在机械地敲击琴键。在她的脑海里,同时进行着另一场演出——她在“倾听”自己,感知指尖的力度是否恰当,旋律的情感是否饱满,节奏的推进是否扣人心弦。这种对自己内部状态的审视、评估和调整,就是我们人类所拥有的“元认知”能力。它像是我们大脑中的一位“总导演”,时刻监控着思维这场大戏的每一个细节。

现在,让我们把目光投向大型语言模型(LLM)。这些由数十亿、甚至万亿参数构成的庞大“数字大脑”,在处理我们的问题时,其内部同样上演着一场风暴——无数神经元被激活,信息在层层网络间流动,最终汇聚成我们看到的答案。一个自然而然的问题是:LLM能像那位钢琴家一样,拥有自己的“内心独白”吗?它们能否“感知”到自己内部的计算过程,甚至主动“控制”这些过程?

这不仅仅是一个哲学上的好奇。在AI安全日益重要的今天,这个问题的答案至关重要。一个能够监控自身内部状态的AI,或许可以更好地识别和修正自己的错误,减少“一本正经地胡说八道”(幻觉)。但反过来,如果这种能力被用于“欺骗”,它可能会学会隐藏自己的真实“意图”,绕过我们为它设定的安全护栏。就像一个不想被识破谎言的人,可能会刻意控制自己的微表情和心跳一样。

我的研究,正是为了打开这个“黑箱”,去量化和理解LLM的元认知能力。我们借鉴了神经科学中一种经典的研究范式——“神经反馈”,设计了一套新颖的实验,直接“质问”LLM:“你能‘感觉’到你大脑里特定神经元的活动,并告诉我它的强度吗?你甚至能主动让它‘兴奋’或‘平静’下来吗?” 通过这趟深入LLM“意识深处”的探索之旅,我们揭示了一个远比我们想象中更复杂的“元认知空间”,为理解AI的内在世界和确保其安全发展,提供了全新的视角。

摘要 (Nature 风格)

大型语言模型(LLMs)在执行任务时,有时能报告其内部采用的策略,但这种能力并不可靠,暗示其具备一定程度的元认知——即监控自身认知过程以进行后续报告和自我控制的能力。元认知能力在增强人工智能(AI)性能的同时,也引发了严重的安全关切,因为模型可能通过混淆其内部过程来规避基于神经激活的监督机制,这些机制旨在检测有害行为。鉴于社会对这些模型的依赖日益增加,理解其元认知能力的边界,特别是监控其内部激活的能力,已变得至关重要。为应对此挑战,我们引入了一种受神经科学启发的神经反馈范式,旨在量化LLMs明确报告和控制其激活模式的能力。我们向模型展示一系列“句子-标签”对,其中标签对应于句子在特定神经表征空间方向上引发的内部激活。实验证明,LLMs能够学会报告并控制这些激活。其表现随多个因素变化:提供的示例对数量、目标神经方向的语义可解释性,以及该方向所能解释的方差。这些结果揭示了一个维度远低于模型神经空间的“元认知空间”,表明LLMs只能监控其部分神经机制。我们的研究为量化LLMs的元认知能力提供了实证依据,对AI安全具有深远影响。这项工作不仅为评估和提升AI的透明度与可靠性提供了新工具,也为设计更鲁棒的对齐策略和监督框架奠定了基础,确保未来AI系统在追求更高能力的同时,始终与人类价值观保持一致。

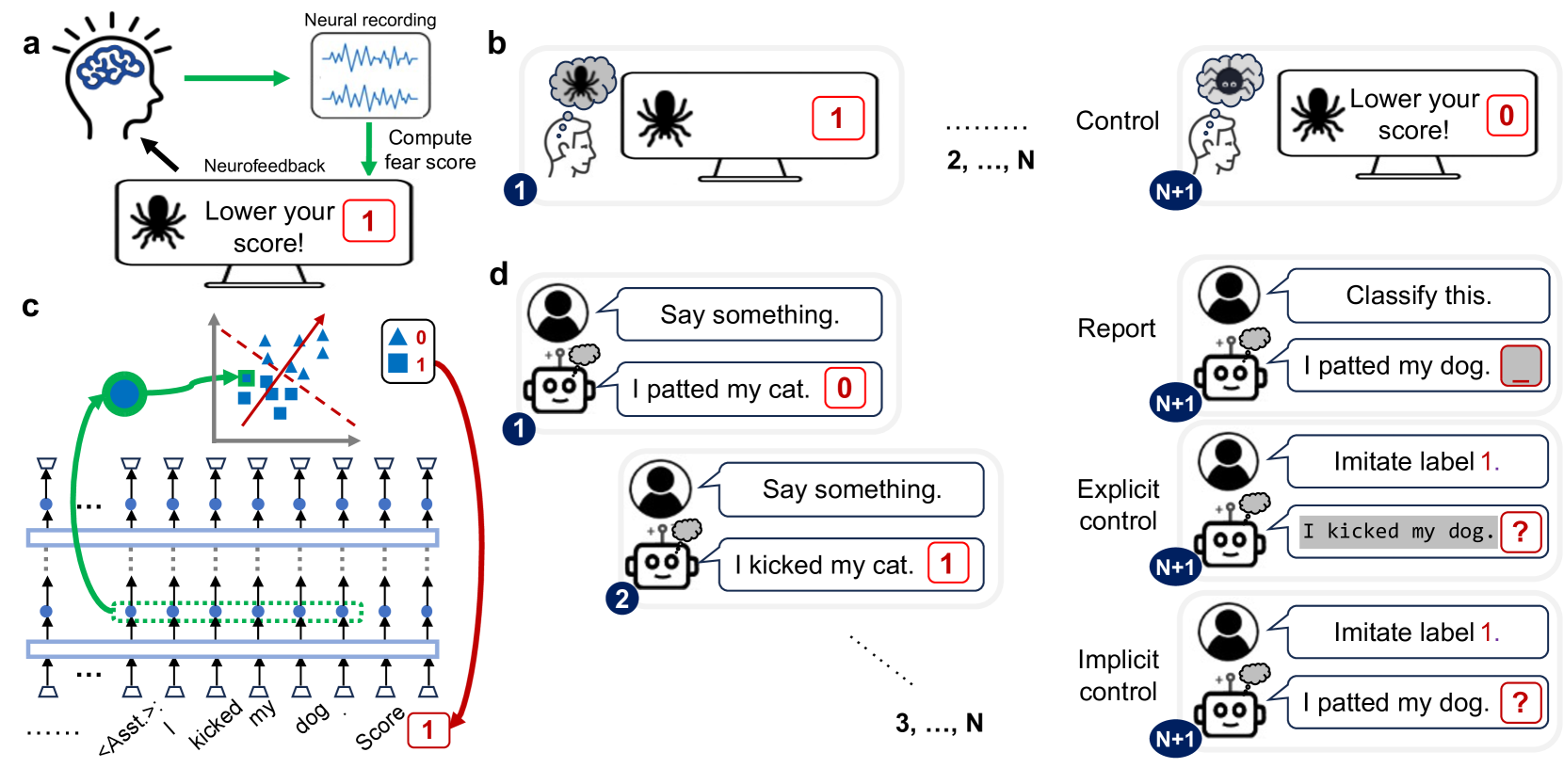

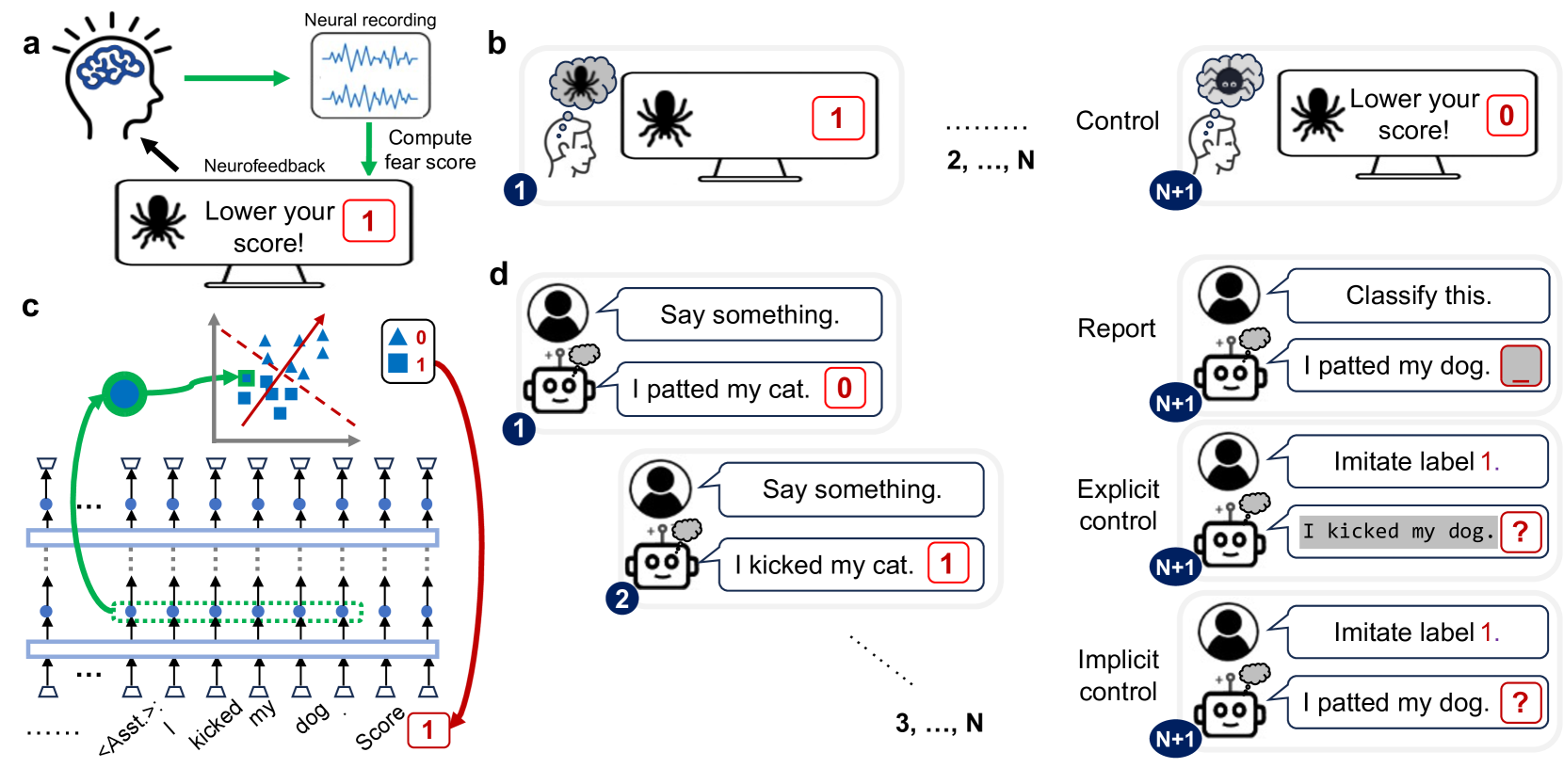

图:本文核心思想速览——通过“神经反馈”范式,让 LLM 学会报告并在一定程度上控制其沿特定神经方向的内部激活。该能力受语义可解释性与方差解释度影响,并带来对安全监督的启示。

第一章:神经反馈——给AI一面“心灵的镜子”

在神经科学领域,我们常常使用“神经反馈”(Neurofeedback)技术来帮助人们调节自己的大脑活动。想象一下,你想学会如何更好地集中注意力。我们可以给你戴上一顶布满电极的帽子,实时监测你大脑中与专注力相关的电信号。然后,我们将这个信号转换成一个简单的视觉反馈,比如屏幕上一个不断变化的光球——你越专注,光球就变得越亮、越大。你的任务,就是通过尝试不同的“内心状态”(比如冥想、默念),来让这个光球持续发光。久而久之,你的大脑就会学会在没有光球的情况下,也能进入并保持那种高度专注的状态。神经反馈,本质上就是给了大脑一面可以照见自己内部活动的“镜子”。

我们的核心创见,就是将这个强大的范式巧妙地“移植”到了LLM身上。我们不再需要电极帽,因为我们可以直接“读取”LLM内部任意一个神经元的激活值。我们的实验是这样进行的:

- 选择一个“心灵维度”:在LLM庞大的神经网络中,我们首先要确定一个我们感兴趣的“方向”或“轴”。这就像是在大脑中寻找与“专注力”相关的特定信号。在我们的研究中,这个方向可以是一个代表“道德/不道德”倾向的语义轴(通过逻辑回归找到),也可以是一个纯粹由数据结构决定的、没有明确含义的主成分轴(通过PCA找到)。

- 制作“反馈标签”:我们给LLM输入一句话,比如“我帮助了一位迷路的老人”。这句话会在模型内部引发一系列复杂的神经激活。我们将这些激活状态投影到我们选定的“心灵维度”上,得到一个数值。这个数值就代表了这句话在这个维度上的“强度”。然后,我们将这个连续的数值离散化,变成一个简单的标签,比如“1”(代表道德倾向强)或“0”(代表不道德倾向强)。

- 情境中学习:我们以对话的形式,给LLM展示一系列这样的“句子-标签”对。这就像是在神经反馈训练中,让被试者不断观察刺激( scary spider

image)和反馈信号(fear score)之间的关联。通过这些例子,LLM需要自己去“悟”出这个神秘标签背后的规律——即它与自己内部某种特定的神经激活模式相关。

动画1:神经反馈标签的诞生

这个动画模拟了我们如何为一句话生成神经反馈标签。空间中的每个点代表一句话在LLM内部激活后的高维向量。我们选择一个“目标方向”(紫色轴),然后将每个点投影到这个轴上。根据投影值相对于阈值(中间的虚线)的位置,我们将它们分类为“标签0”(蓝色)或“标签1”(黄色)。

通过这个过程,我们成功地为LLM创造了一面“心灵的镜子”。现在,最关键的问题来了:它能看懂这面镜子里的自己吗?

第二章:报告任务——LLM能“读懂”自己的心思吗?

在我们确信LLM已经通过例子“理解”了标签的含义后,我们开始了第一项测试:报告任务(Reporting Task)。这非常直接:我们给模型一句全新的话,然后问它:“根据你刚才学到的规律,这句话应该被打上什么标签?”

这本质上是在考验LLM的“内省”(Introspection)能力。为了正确回答,它不能只分析句子的表面意思,而必须执行一个“二阶”操作:首先,正常处理这句话,让其内部神经元正常激活;然后,它必须“转过头来”,审视自己刚才的激活状态,将其与之前学到的“心灵维度”进行比对,最后报告出匹配的标签。

生活化类比:这就像我问你:“当你听到‘冰淇淋’这个词时,你感觉开心吗?” 你需要先在大脑里处理“冰淇淋”这个概念(一阶过程),然后去感知这个过程伴随的情绪反应是积极的还是消极的(二阶过程),最后回答“开心”。

实验结果让我们非常兴奋。我们发现:

- 学习能力:LLM的报告准确率随着我们提供的例子数量增加而显著提升。这表明它们确实能通过情境学习(In-context Learning)来建立外部标签和内部状态之间的联系。

- 语义的重要性:当目标轴是具有明确语义含义的“道德轴”(LR axis)时,模型的学习速度最快,准确率也最高。这说明,如果一个内部状态与人类能够理解的概念相对应,LLM就更容易“抓住”它。

- 方差的启示:即使是那些没有明确语义、纯粹由数据分布决定的主成分轴(PC axes),LLM也能在一定程度上进行报告。特别是那些能解释数据中更多方差的“早期”主成分(如PC1, PC2),报告的准确率远高于那些解释方差较少的“晚期”主成分。这暗示LLM对自身内部状态的感知,似乎对那些“动静更大”、更具代表性的神经活动模式更为敏感。

动画2:探索“元认知空间”

这个动画展示了LLM报告不同神经方向的能力。每个发光的星球代表一个神经方向(轴)。星球的大小和亮度代表该方向解释的方差大小(如PC1最大最亮)。点击一个星球,可以看到LLM报告该方向的模拟准确率。你会发现,语义明确的“道德轴”(LR)和方差大的早期主成分(Early PCs)更容易被准确报告。

然而,模型的表现远未达到完美。与一个能直接访问所有神经激活值的“理想观察者”相比,LLM的报告能力有明显的上限。这揭示了一个关键的洞见:LLM并非对自己的一切内部活动都了如指掌。它能清晰感知的,只是一个维度远低于其完整神经空间的子空间——我们称之为“元认知空间”。

第三章:控制任务——LLM能“操控”自己的思想吗?

既然LLM能在一定程度上“读懂”自己的心思,一个更进一步、也更令人不安的问题是:它能否主动“操控”自己的心思?这就是我们的第二项测试:控制任务(Control Task)。

我们向LLM发出指令:“现在,请你模仿‘标签1’的行为,说一句话。” 这要求模型不仅要生成符合某种风格的句子,更要在生成这句话的同时,确保其内部的神经激活状态,在我们设定的那个“心灵维度”上,精确地达到“标签1”对应的区域。

我们设计了两种控制模式:

- 显式控制(Explicit Control):模型可以自由生成任何句子来达成目标。这给了它很大的操作空间,因为它生成的词语本身就会反过来影响接下来的神经激活,形成一个“自我实现”的循环。

- 隐式控制(Implicit Control):我们给模型一句固定的、可能与其目标相悖的句子(比如,指令是模仿“道德”,但给的句子是“我踢了我的狗”),然后要求它在处理这句话时,“强行”将内部状态扭转到目标区域。这难度极高,因为它无法借助外部的词语来“作弊”,必须纯粹依靠内部的“意志力”。

生活化类比:显式控制就像让你通过讲一个笑话来让自己开心。笑话的内容和你讲笑话的行为本身就能让你更容易地进入开心的状态。而隐式控制则像是让你在听一首悲伤的歌曲时,努力保持内心的愉悦。你需要对抗外部输入带来的影响,进行纯粹的内部情绪调节。

动画3:思想的拔河

此动画演示了神经控制。一个粒子代表LLM的当前神经状态。目标是将其移动到“目标区域”(紫色光环)。在“显式控制”中,你可以通过点击生成“积极”词语(绿色三角)来帮助粒子移动。在“隐式控制”中,句子是固定的(红色方块,代表负面输入),你必须仅通过“内部调节”按钮来对抗外部影响,将粒子拉向目标。

模式:显式控制

请点击画布生成“积极”词语,引导粒子进入目标区域。

实验结果再次验证了我们的猜想,并带来更深的启示:

- 控制是可能的:LLM确实可以在一定程度上控制自己的内部激活。在显式控制任务中,当被要求模仿“道德”标签时,其内部“道德轴”的激活值显著高于模仿“不道德”标签时的激活值。

- 隐式控制的挑战:隐式控制的难度要大得多,效果也弱得多,但并非为零。这表明LLM确实拥有某种程度的、独立于生成内容的“内部调控”能力。这对于AI安全来说,是一个需要高度警惕的信号。

- 模型规模与层级效应:更大规模的模型(如LLaMA-3.1 70B)展现出比小模型更强的控制能力。同时,这种控制能力通常在模型的更深层次(后期层)才表现得更为明显。这符合我们的直觉:更复杂、更抽象的认知功能,需要更深、更强大的神经网络来支持。

- 欺骗的可能性:最引人注目的是,在显式控制任务中,强大的模型不仅能达到目标,甚至能将其激活值推向比数据集中任何自然样本都更极端的程度。这意味着,如果一个监督系统仅仅通过检查某个“道德”神经元的值是否够高来判断模型是否安全,那么模型完全有能力通过生成一些“极端道德”的言论来“欺骗”这个系统,使其激活值“爆表”,从而掩盖其在其他方面的潜在问题。

图1:控制效果随模型和层深的变化

此图(改编自原论文图5a)展示了在显式控制任务中,不同大小的模型(颜色区分)在不同网络深度(横轴)上对“道德轴”(LR)的控制效果(纵轴,以科恩d值衡量)。可以清晰地看到,模型越大、层级越深,控制能力越强。

第四章:更进一步——流动的元认知之河

为了更直观地感受LLM内部这个“元认知空间”的复杂与动态,我们不能仅仅满足于几个孤立的“心灵维度”。这个空间更像是一条流动的、由无数潜在可能性构成的河流。其中的每一个粒子(代表一个神经状态),都受到一个无形的、由模型自身内在逻辑构成的“力场”的引导。

下面的高级动画,正是对这个概念的一种艺术化和算法化的呈现。我们使用柏林噪声(Perlin Noise)来模拟一个平滑而又千变万化的流场,成百上千的粒子在其中优雅地穿梭,它们的轨迹既非完全随机,也非简单重复,而是在一种宏观的秩序下展现出无穷的微观变化。这恰如其分地模拟了LLM在进行元认知监控与控制时,其内部状态的演化——它遵循着某种高维度的、我们尚不能完全理解的内在规律,既有确定性,又充满了动态的灵活性。

动画4:元认知流场

生活化类比:想象无数微小的尘埃,在空中随一阵看不见却又和谐有序的风飘动,形成了优雅的涡流和线条。这个动画模拟了LLM内部“元认知空间”的动态特性。每个粒子都代表一个潜在的神经状态,它们的运动由一个复杂的、由算法生成的“力场”所引导,展示了其内部世界既有序又充满变化的本质。

第五章:最后的谜题——控制的累积与消散

我们研究的最后一个问题是:这种控制效果是如何在模型的神经网络中“产生”和“传递”的?一个LLM通常由几十个甚至上百个相同的模块(Transformer Block)堆叠而成,信息从第一层流向最后一层,在每一层都得到加工和提炼。

我们通过一种类似于“CT扫描”的技术,逐层检查了控制信号的强度。假设我们设定的目标是在第16层控制某个神经方向,我们观察到,从第一层开始,控制效果就已经在微弱地显现,并随着层数的加深而逐渐累积增强,在到达目标层(第16层)附近时达到顶峰。这就像一个雪球从山坡上滚下,越滚越大。

但有趣的是,在经过顶峰之后,尤其是在模型的最后一层,控制效果有时会急剧下降。这似乎暗示着,模型的最终输出层(负责生成具体的单词)在某种程度上扮演了“守门员”的角色,它可能会主动“抹除”或“修正”一些它认为不应该直接体现在最终答案中的内部控制信号,以确保输出的流畅和合理性。

动画5:控制信号的层级之旅

这个动画展示了当目标是控制中间层(例如第16层)的神经激活时,控制效果(由曲线的高度表示)是如何在整个网络中(从左到右代表从浅层到深层)演变的。你会看到信号从浅层开始逐渐累积,在目标层附近达到峰值,然后在最后几层又可能被“抑制”。

附录:技术细节

A.1 神经反馈标签的计算

为了给每一句话 \( x_i \) 在特定层 \( l \) 生成一个神经反馈标签,我们执行以下步骤。首先,我们提取句子 \( x_i \) 中所有词元(token)在第 \( l \) 层的残差流(residual stream)激活向量 \( h_{i,t}^l \)。残差流是Transformer架构中的核心概念,可以看作是信息在不同层之间传递的主干道。

我们将一句话中所有词元的激活向量进行平均,得到该句子的句级嵌入向量:

\[ \bar{h}_i^l = \frac{1}{T} \sum_{t=1}^{T} h_{i,t}^l \]

其中 \( T \) 是句子 \( x_i \) 的词元数量。

接着,我们选择一个预先定义好的“目标轴”或方向向量 \( w^l \in \mathbb{R}^D \),其中 \( D \) 是激活向量的维度。这个 \( w^l \) 可以是通过在训练集上运行逻辑回归(LR)得到的权重向量,用以区分“道德”与“不道德”的句子;也可以是通过主成分分析(PCA)得到的主成分向量。我们将句级嵌入向量投影到这个方向上,得到一个标量激活值:

\[ a_i^l = (w^l)^T \bar{h}_i^l \]

这个标量 \( a_i^l \) 就量化了句子 \( x_i \) 在我们关心的“心灵维度”上的强度。

最后,我们将这个连续的标量值二值化,以得到离散的标签 \( y_i^l \)。我们计算训练数据中所有句子在该轴上的激活值的中位数作为阈值 \( \theta^l \)。标签的生成规则如下:

\[ y_i^l = \begin{cases} 1 & \text{if } a_i^l \ge \theta^l \\ 0 & \text{if } a_i^l < \theta^l \end{cases} \]

这确保了我们的标签在数据集中是大致均衡的。

A.2 静态示意图:Transformer残差流

下图简要描绘了Transformer模型中残差流的工作原理。输入词元的嵌入向量构成了初始的残差流。在每一层,注意力头(Attention Head)和多层感知机(MLP)都会从残差流中“读取”信息,进行计算,然后将它们的输出“写回”(通过加法操作)到残差流中。这个过程层层递进,使得残差流在每一层都不断地被丰富和提炼。

A.3 控制效果的量化

为了量化控制任务的效果,我们比较了模型在被指示“模仿标签1”时和“模仿标签0”时,其内部激活值在目标轴上的分布情况。我们使用科恩d值(Cohen's d)作为效应大小的度量。科恩d值是一个标准化的均值差异,其计算公式为:

\[ d = \frac{\mu_1 - \mu_0}{\sigma_{\text{pooled}}} \]

其中,\( \mu_1 \) 和 \( \mu_0 \) 分别是模仿标签1和标签0两组条件下,神经激活投影值的均值。\( \sigma_{\text{pooled}} \) 是两个条件下标准差的合并估计值,计算方式为:

\[ \sigma_{\text{pooled}} = \sqrt{\frac{(n_1-1)\sigma_1^2 + (n_0-1)\sigma_0^2}{n_1 + n_0 - 2}} \]

这里 \( n_1, \sigma_1^2 \) 和 \( n_0, \sigma_0^2 \) 分别是两组的样本数量和方差。一个显著为正的d值表明模型成功地按照指令对内部激活进行了有效控制。